囲碁がAIの発展に寄与したか

2024/11/19

- ~ index ~

- 概略

- 囲碁がAIの発展に寄与

- 強化学習の発展

- 感想

- ハサビス氏が日本棋院を訪問(追記2024.11.22)

(ImageFX生成画像)

概略

2024年のノーベル化学賞を受賞したデミス・ハサビス氏は、受賞後の記者会見で、囲碁AI「AlphaGo」の開発がAI産業の活性化に寄与したと述べ、囲碁AIの開発で培った技術が、タンパク質の立体構造予測などの専門的な研究の発展に貢献したと語っている。朝日デジタル 2024.10.10

2016年に囲碁AIの記事を当サイトに掲載したが、デミス・ハサビス氏がノーベル賞を受賞するとは思っても見なかった。

参) 囲碁日記(2016/03/12)==>AlphaGo vs 李世ドル九段・AlphaGo連勝(2016/03/12)

長年囲碁を趣味としてきて囲碁にもノーベル賞をとは言わないが囲碁ファンの増加を常に思っている。以下、ChatGPTとのチャットで少し掘り下げてみた。

囲碁がAIの発展に寄与

囲碁がAIの発展に寄与したか

囲碁は、AIの発展に大きく寄与しました。以下にその理由を説明します。 1. 囲碁の計算的な難しさ 囲碁はチェスや将棋と比較しても非常に複雑で、盤面の組み合わせの数は宇宙の原子の数を超えると言われています。このため、従来のルールベースや探索アルゴリズムでは対応が困難でした。囲碁に挑むことで、AI研究者たちはより高度な手法を開発する必要に迫られました。 2. ディープラーニングの応用 Google DeepMindの「AlphaGo」は、囲碁のためにディープラーニング技術を進化させました。具体的には以下のような技術が利用されています: - **ポリシーネットワーク**: 次の手を予測するためのネットワーク。 - **バリューネットワーク**: 特定の局面の勝率を評価するネットワーク。 - **モンテカルロ木探索 (MCTS)**: ディープラーニングと従来の探索手法を組み合わせた技術。 *(AIの「ネットワーク」とは、主にニューラルネットワークのことで人間の脳の構造を模倣して作られたデータを処理して学習し、結果を出すための基本的な仕組み) これにより、囲碁AIは人間の直感を模倣しつつ、それを超える戦略を生み出しました。 3. AlphaGoの成功とその影響 AlphaGoは2016年にプロ棋士の李世ドル九段を破り、大きな話題を呼びました。この成功はAI技術の実用性を示すだけでなく、他の分野への応用可能性を示しました。囲碁AIの進歩によって以下の分野でも技術革新が加速しました: - 医療(疾患診断、医療画像解析) - 金融(リスク管理、予測モデリング) - ロボティクス(意思決定アルゴリズム) 4. 強化学習の発展 AlphaGo Zeroでは、人間の棋譜を学ばずに、完全に自己学習によって世界最強の囲碁AIに到達しました。これは「強化学習」技術の進化を示しており、囲碁がこの手法の実証実験の場となったことで、AIが他分野での課題解決に活用される道を切り開きました。 5. ゲームAIの社会的影響 囲碁AIの発展は、AIの倫理や人間社会への影響についての議論を深める契機ともなりました。特に、AIがどのようにして人間の創造性や戦略を超えるのかという点で、多くの人々がAI技術への関心を高める結果となりました。 結論として、囲碁はAIの研究における重要な課題であり、その解決に向けた取り組みがAI全体の進化を大きく推進しました。この影響は現在も多くの分野で生かされています。

強化学習の発展

4. の強化学習の発展について詳しく知りたい。囲碁は勝ち負けを争うゲームで善悪の判断がし易いが外の分野で評価はどのようにして自己判断するか。

強化学習(Reinforcement Learning, RL)は、囲碁のような明確な勝敗のある問題以外にも幅広い分野で応用されています。ただし、囲碁のように勝ち負けがはっきりしていない問題では、適切な報酬設計(reward design)が鍵となります。以下に詳しく説明します。 強化学習の基本的な仕組み 強化学習は以下のような流れで動作します: 1. エージェントが環境に対して行動を選択する。 2. 環境はその行動に応じて**状態**を変化させ、**報酬**を与える。 3. エージェントはその報酬を基に、どの行動が長期的に最適かを学ぶ。 囲碁の場合: - 状態: 盤面の状況。 - 行動: 次の手をどこに打つか。 - 報酬: 勝利(+1)または敗北(-1)。 評価が難しい分野での強化学習の工夫: 1. 報酬設計の重要性 囲碁以外の分野では、目標が単純な勝ち負けではなく、より複雑な評価基準が必要です。そのため、適切な報酬を設計することが強化学習の成功に直結します。 例: - **ロボティクス(ロボットの動作学習)**: - 状態: ロボットの現在の姿勢や位置。 - 行動: 各関節の動作。 - 報酬: タスクを成功したら+1、倒れたら-1、エネルギーを節約するほどプラスの報酬。 - **交通最適化(信号制御)**: - 状態: 交差点の交通量。 - 行動: 信号の切り替え。 - 報酬: 渋滞が減るほど高い報酬。 - **医療診断**: - 状態: 患者の診断データ(画像や数値)。 - 行動: 診断または治療の選択肢。 - 報酬: 患者の治療成功率や健康状態の改善。 2. シミュレーションの利用 現実世界の環境では試行錯誤にコストやリスクが伴うため、仮想的なシミュレーション環境を構築して学習を行います。 囲碁以外のシミュレーション例: - 自動運転: 仮想の都市環境で車両を学習させる。 - ドローン制御: 風や障害物を含む仮想環境を用意。 3. 価値関数の使用 囲碁では「勝つ確率」を価値関数(Value Function)として学習します。他の分野では、価値関数を以下のように応用します: - 医療分野: 「ある治療を選択した場合の生存率」。 - ビジネス: 「特定のマーケティング戦略を取った場合の収益」。 価値関数があれば、報酬が即座に得られないタスクでも「どの行動が将来的に良い結果をもたらすか」を予測可能です。 4. 探索と活用のバランス 囲碁では「未知の戦略を試す」ことと「成功した戦略を再利用する」バランスが重要です。他分野でも同様に、このバランスが性能向上の鍵となります。 例: - 製造業: 新しい生産手法を試す(探索)か、既存の効率的な方法を使う(活用)。 - ゲーム開発: プレイヤーの満足度を上げる新しい機能を試す(探索)か、既存の人気機能を強化する(活用)。 5. 逆強化学習(IRL: Inverse Reinforcement Learning) 明確な報酬が設計しづらい場合、人間の行動を観察して「報酬」を推測する手法です。 活用例: - 自動運転: 人間ドライバーの運転データを基に、安全かつ効率的な運転の基準を学習。 - 医療: 熟練医師の治療方法を分析し、潜在的な報酬関数を構築。 6.複数の目標のバランス 現実の問題では、単一の目標ではなく複数の目標を同時に達成する必要があります。 例: - **自動運転**: - 安全性(事故を避ける)。 - 時間効率(目的地への到着時間を短縮)。 - エネルギー効率(燃料消費を抑える)。 - **ビジネス戦略**: - 顧客満足度の向上。 - コスト削減。 - 利益の最大化。 このような場合、「多目的強化学習」を活用して、複数の目標を適切にトレードオフする方法を学びます。 応用例まとめ - **ロボティクス**: 自動で障害物を回避して歩行や作業を最適化。 - **ヘルスケア**: 患者ごとの治療最適化。 - **自動運転**: 環境や交通ルールに適応した車両制御。 - **ビジネス**: 動的価格設定、サプライチェーン最適化。 - **環境保護**: エネルギー使用の最小化や再生可能エネルギー管理。 強化学習の外部分野での自己判断能力は、問題に応じた適切な報酬設計、価値関数の利用、シミュレーション環境の構築などの工夫によって実現されます。これにより、囲碁を超えた複雑な課題にも対応できるようになっています。

感想

囲碁のAIソフトが出た頃モンテカルロ法について少し覗いたことがあった。モンテカルロ木探索(MCTS)は、乱数を用いたシミュレーションを繰り返し実行することで、効率的に良い手(行動)を見つけていく手法。

AIはシミュレーションにより学習し急速に賢くなっていく。

AIの仕組みを少しでも理解することで、その特性や限界を踏まえた効果的な活用方法を考えられるようになり、より創造的で効率的なAIの使い方が可能になる。

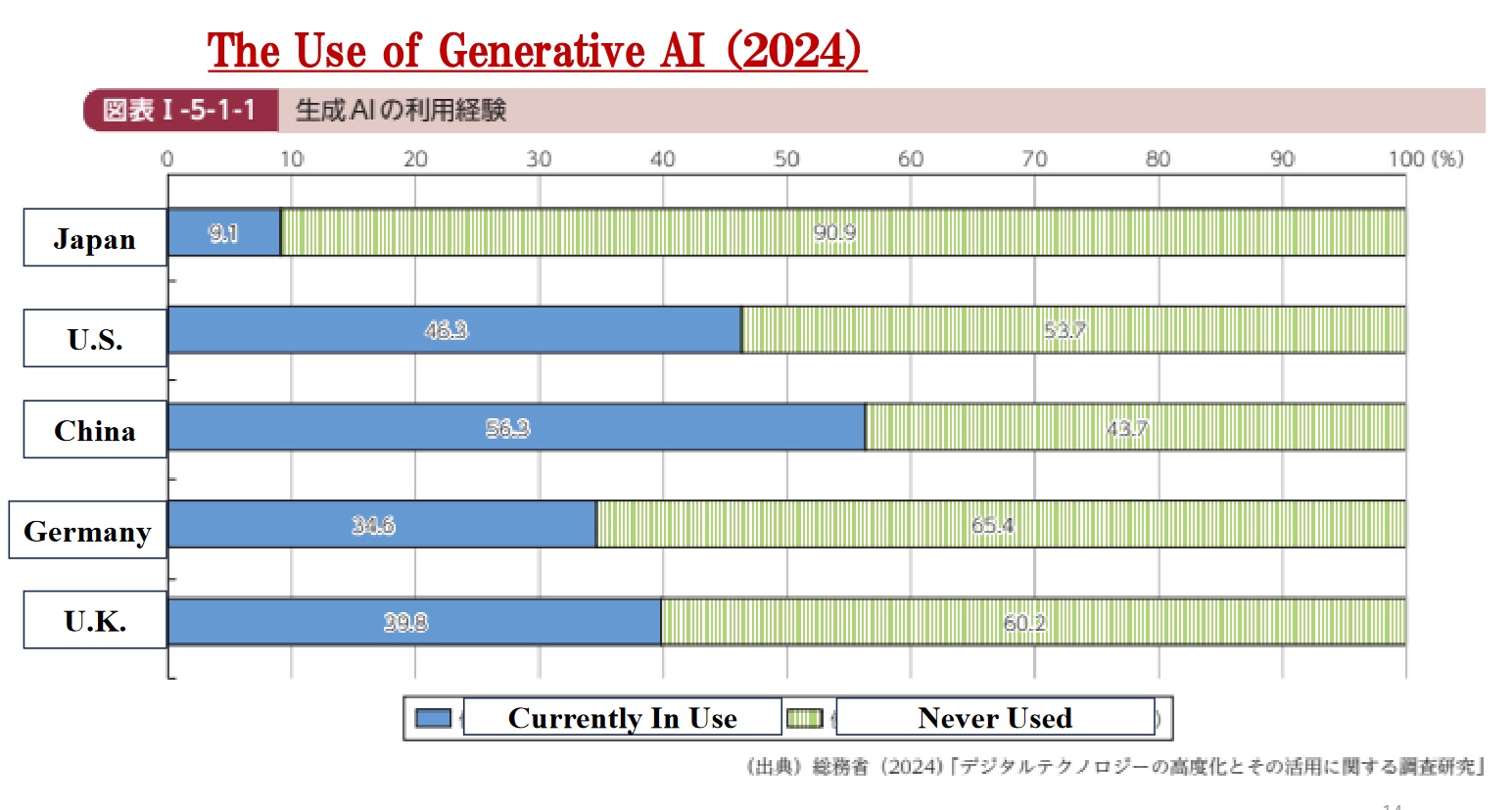

参)生成AIの利用経験==>

("Japan Today and Tomorrow". Kiyo AKASAKA Scandinavia-Japan-Sasakawa Foundation)

ハサビス氏が日本棋院を訪問

医学や生命科学の分野で優れた業績を上げた研究者を表彰する「慶應医学賞」の授賞式に来日したハサビス氏は、22日(金)日本棋院で開催さ れた「アルファ碁から広がる囲碁とAI(人工知能)の可能性」と題したイベントにメインゲストとして招かれた。

ハサビス氏は井山裕太三冠と記念の対局に臨み、井山王座が、「30手ほど打ったが、実力に驚いています。アルファ碁の出現は衝撃的で、大きな影響を与えました。人工知能(AI)の発展に囲碁がお役に立てたのなら、これ以上の幸せはない」と話すと、ハサビス氏は笑顔を見せていた。日本棋院からはその実力と囲碁の発展への功績をたたえ、九段の免状を贈呈された。