Google Labs

2025/01/28

- ~ index ~

- 概要

- 生成画面

- MusicFX生成例

- 感想

- 付記

ImageFX生成画像

概要

生成AI分野におけるマイクロソフトとGoogleの競争構図

生成AIの分野では、マイクロソフトとGoogleが先端技術を巡って熾烈な競争を繰り広げている。マイクロソフトは、OpenAIに多額の投資を行い、同社の技術を活用したサービスを展開している。一方で、Googleは自社のAI技術を基盤とした独自のサービスを進化させ、両社が業界をリードする存在として注目を集めている。

マイクロソフトは、OpenAIの開発した生成AI「ChatGPT」を活用し、「Azure OpenAI Service」(*)や「Microsoft 365 Copilot」などの製品を提供。これにより、生成AIを企業向けのソリューションや日常業務の支援ツールとして活用する道を切り開いている。特に、OpenAIとの提携により、技術面での競争優位性を高めている点が注目される。(*Azure OpenAI Service :企業が高度なAIモデルを安全かつ拡張性の高い活用できるクラウドサービス)

Googleは、独自の生成AI技術を用いた対話型AI「Bard」や、その他の実験的な技術をGoogle Labsで公開。Google Labsは、次世代技術を試験的に展開する場として機能しており、ユーザーからのフィードバックをもとに技術を洗練させる役割を担っている。検索エンジン分野での圧倒的な知見を背景に、生成AIを検索体験や情報提供の質向上に応用している点が特徴だ。

両社の競争は、生成AIの可能性をさらに広げる原動力となっている。マイクロソフトがOpenAIの技術を戦略的に取り込み、ビジネスユースを重視しているのに対し、Googleは検索分野や情報管理との連携を強化するアプローチを取る。この違いが、今後の技術開発や市場の動向にどのような影響を与えるのかが注目される。

生成AIは急速に進化しており、その利便性と影響力はますます高まっている。マイクロソフトとGoogleの競争が、この分野のさらなる発展を促す鍵となるだろう。

The home for AI experiments at Google : Google Labs

まずは Labs.google/fx にGoogleアカウントで log on :

今回はMusicFXを試してみた

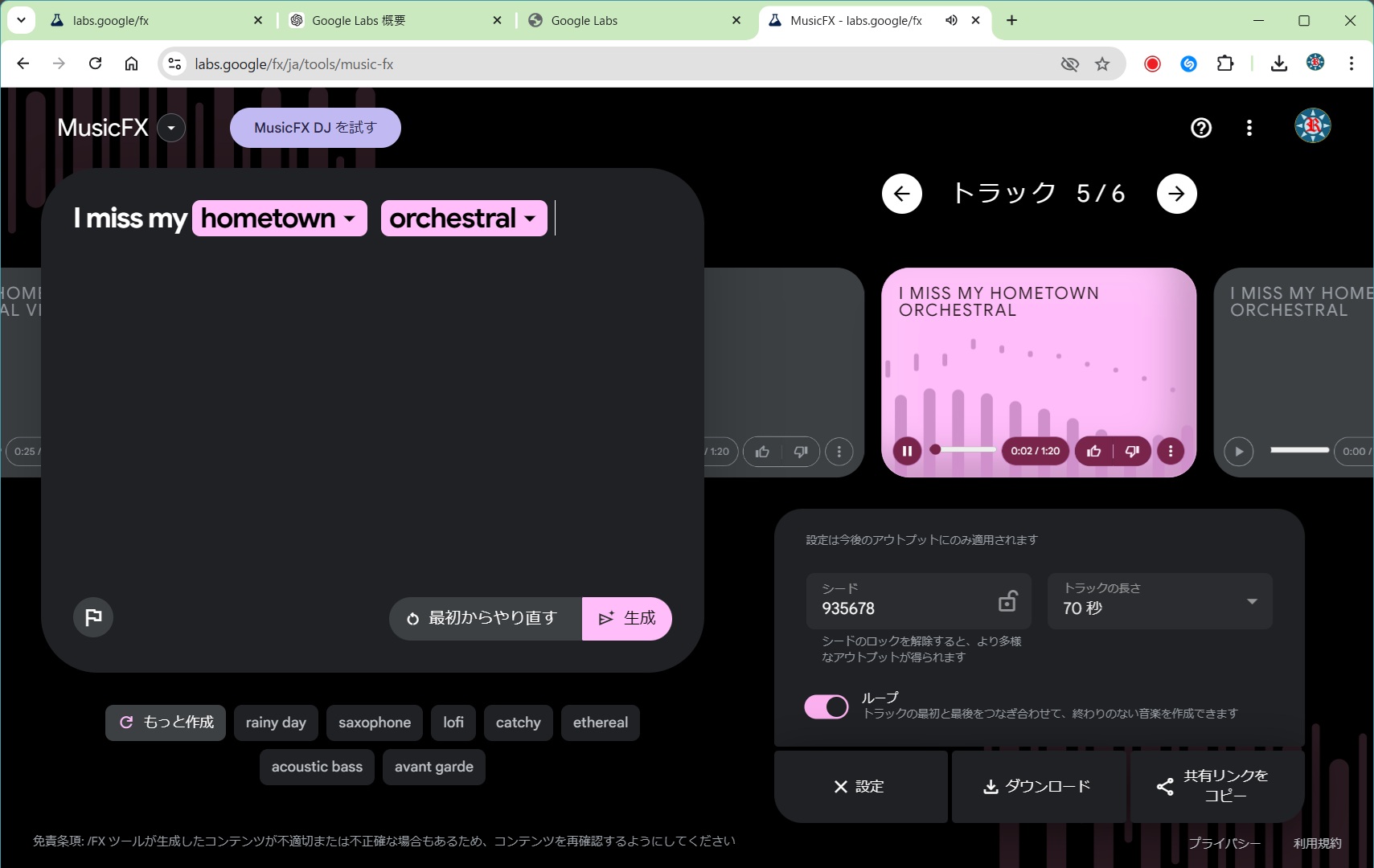

生成画面

-

プロンプト " I miss my hometown "を入力

左下「もっと作成」で生成したい楽曲のイメージやスタイル、使用したい楽器、感情などを指定(英語)

右下「設定」で時間の指定。最大70秒

「生成」で生成開始。

MusicFX生成例

「I miss my hometown - orchestral」

「I miss my hometown - electronic」

「I remember my hometown - classcal」

「I remember my hometown - country」

感想

生成された音楽はラボ仕様のため、再生時間が最大で約70秒程度に制限されており、時間が経つと突然終了する。また、楽器はピアノ、フルート、トランペット、ギターなどを指定できるが、音質に関してはまだ改善の余地があると感じる。

付記

生成AIは特に音楽はどのように評価して作品の価値を上げるのか

生成AIが音楽を評価し、その価値を向上させる方法は多岐にわたります。以下にその主要なポイントを挙げます。 1.楽曲の分析と評価 生成AIは楽曲を評価するために以下のような技術を使用します: - 音響分析: ピッチ、リズム、テンポ、音色などの要素を解析し、楽曲の構造を理解します。 - 感情分析: 楽曲が引き起こす感情(悲しみ、喜び、興奮など)を判断し、リスナーに与える影響を評価します。 - ジャンル分類: 楽曲を特定のジャンルに分類し、そのジャンル内での独自性や品質を比較します。 2. AIによる作曲アシスト AIはアーティストが楽曲の価値を高めるために以下の方法で支援します: - リアルタイムフィードバック: メロディやコード進行に対して改善点や新しいアイデアを提案。 - スタイル模倣: 特定のアーティストやジャンルのスタイルを模倣し、インスピレーションを提供。 - バリエーション生成: 同じ楽曲の異なるアレンジやバージョンを提案し、多様性を広げます。 3. パーソナライゼーション リスナーの好みに合わせた楽曲を提案・生成することで、音楽の価値を高めます: - リスナーの履歴分析: 過去の再生履歴から好みの特徴を学習し、それに合わせた新しい楽曲を生成。 - ダイナミックプレイリスト: リアルタイムのムードや環境に合わせてカスタマイズされた音楽体験を提供。 4. 新しい音楽の可能性の発掘 AIは既存のルールに縛られず、革新的な音楽を作り出すことで価値を高めます: - 異ジャンルの融合: 異なるジャンルや文化の要素を組み合わせ、新しいスタイルを開発。 - 未使用の音響技術: 人間が気づきにくい音響効果や配置を活用し、新しいサウンドを生み出します。 5. 商業的価値の向上 AIは音楽制作だけでなく、そのマーケティングや配信にも貢献します: - トレンド予測: 人気が出そうなスタイルやテーマを予測して制作に活かします。 - プロモーション最適化: ソーシャルメディアやストリーミングプラットフォームでの効果的な拡散方法を提案。 - シンクライセンス: 映画、ゲーム、広告など、他のメディアでの使用を想定した音楽を生成。 6. 教育とクリエイティブサポート AIはアーティストの成長を助け、音楽の価値を広げます: - 学習ツール: 初心者が音楽理論や作曲技術を学ぶためのインタラクティブな教材を提供。 - コラボレーション: 人間とAIが共同で音楽を制作し、新たな発見や技術の向上につなげます。 生成AIが音楽分野において価値を高めるポイントは、技術的精密さと創造的自由の両方を活用して、アーティストとリスナー双方に新しい体験を提供することです。あなたの興味のある具体的なポイントがあればさらに掘り下げてお答えします!

感情分析についてもっと詳しく

感情分析に関して、音楽における生成AIの取り組みをもう少し詳しく説明します。音楽は感情と深く結びついており、感情分析はリスナーに感動を与える楽曲を制作するために重要な役割を果たします。 1. 感情分析の仕組み 生成AIは音楽の感情を分析する際に、以下の手法やデータを利用します: ① 音響特徴量の解析 - ピッチ(音の高さ): 高い音は明るく楽しい感情、低い音は落ち着いたまたは悲しい感情を表現する傾向があります。 - テンポ(速度): 速いテンポはエネルギーや興奮を感じさせ、遅いテンポはリラックスや悲しみを引き起こします。 - ダイナミクス(音量の変化): 繊細な音量の変化や強弱が、感情のニュアンスを伝えます。 - 音色(ティンバー): 弦楽器、ピアノ、電子音など、それぞれの音色が特定の感情を呼び起こします。 ② 感情モデル AIは心理学に基づいた感情モデルを活用して楽曲の感情を分類します: - ヴァレンス・アロウザルモデル: 音楽をポジティブ・ネガティブ(ヴァレンス)と、興奮・落ち着き(アロウザル)の2軸でマッピングします。 - 例:アップテンポのポップソング → ポジティブで興奮状態 - 基本感情理論: 喜び、悲しみ、怒り、驚き、恐れなどの基本感情を分類。 - 多次元モデル: 感情をより細分化し、微妙なニュアンスを捉える。 2. 感情分析の応用 生成AIは感情分析を活用して、さまざまな用途で楽曲の価値を高めています: ① リスナーに最適な音楽を提案 - 状況やムードに合わせたプレイリスト: AIはリスナーの現在の感情(たとえば、リラックスしたい、運動中にモチベーションを上げたいなど)に適した楽曲を提案します。 - 生体データとの連動: 心拍数やストレスレベルをモニタリングし、リアルタイムで感情にマッチした音楽を選択します。 ② 作曲アシスト - AIは作曲中のアーティストに対し、「このメロディは悲しみを引き起こす傾向があります」「リフ(*)を明るくするためにキーを変えてみてはどうですか」といった感情ベースのフィードバックを提供します。(*リフ:特定の楽曲で繰り返し使われる短いフレーズ) ③ 映画やゲーム音楽への適用 - 映像作品のシーンに合った感情を補強するため、AIは特定の感情を強調する音楽を生成します。たとえば、緊張感のあるシーンには低音が響くサウンドスケープを提案します。 ④ リスナーの感情分析 - AIはリスナーが楽曲を聴いた後の感情反応をモニタリングし、それをもとに楽曲の感情的影響を評価します。 - SNSやレビューサイトでのコメント解析により、楽曲が引き起こす感情をテキストデータからも補足します。 3. 技術的アプローチ 感情分析を支える具体的な技術: - 機械学習モデル: 音楽データセットをトレーニングして感情と音楽特徴量の関係を学習します。 - 例:Spotifyが使用する「音楽DNA」アルゴリズム。 - 自然言語処理(NLP)との融合: 歌詞の感情を解析し、楽曲全体の感情と一致させます。 - 例:「悲しげな歌詞」と「ゆっくりしたメロディ」の組み合わせを検出。 - ニューラルネットワーク: 深層学習モデルが音楽の微細なニュアンス(例えば、微妙な和音の変化)を捉え、感情を正確に分析。 4. 感情分析の今後の可能性 感情分析は以下のような形でさらなる発展が期待されます: - 個人化された楽曲制作: 個人の過去の感情データに基づいて、特定のリスナー向けにカスタマイズされた楽曲を生成。 - インタラクティブ音楽: リスナーのリアルタイムの感情に応じて、楽曲のメロディやアレンジが変化するシステム。 - セラピー用途: AIが感情状態に合った音楽を提案し、リスナーのメンタルヘルスをサポート。 音楽の感情分析は、技術的には複雑ですが、リスナーの体験をより豊かにする重要な鍵となっています。